Heres integra nel proprio prodotto modelli generativi, in particolare LLM (Large Language Model), per progettare soluzioni di Conversational AI avanzate.

Ciò è reso possibile da un approccio ibrido NLU-LLM e dall’utilizzo di tecniche RAG (Retrieval Augmented Generation), che consentono una gestione ottimale dell’esperienza conversazionale e permettono di applicare la potenza creativa del modello di AI generalista (foundation model) al dominio di conoscenza specifico del Cliente.

Scelta del modello: un approccio tailor-made

Il prodotto Heres consente l’integrazione con qualsiasi LLM sul mercato che esponga delle API: in base alle peculiarità del progetto e alle esigenze specifiche del cliente, è quindi possibile scegliere se integrarsi a GPT (tramite OpenAI o Microsoft), a Google Gemini, a Claude o a qualsiasi altro modello. L’infrastruttura Heres consente, inoltre, di sostituire il modello integrato o di utilizzare più modelli su uno stesso agente. Ciò permette di gestire agevolmente le problematiche legate all’obsolescenza dei modelli, integrando sempre tecnologie allo stato dell’arte.

Controllo della Knowledge Base: tecniche di RAG

Il Retrieval-Augmented Generation (RAG) è un insieme di tecniche basate sull’uso di LLM con conoscenza generalista a cui si combina la conoscenza specialistica di dominio del Cliente, per orchestrare logiche conversazionali e generare risposte. L’utilizzo di questa metodologia permette di esercitare un notevole controllo sulle risposte generate, riducendo in modo estremamente significativo il tasso di allucinazioni.

L’infrastruttura Heres consente sia di gestire la fase di Retrieval con un’integrazione “tradizionale” (es chiamata API al motore di ricerca del sito del Cliente) sia tramite ricerca semantica su un database vettoriale. In quest’ultimo caso, Heres si fa carico della creazione e della manutenzione del database vettoriale, grazie a un’infrastruttura dedicata, basata su soluzioni Open Source quali LLama Index.

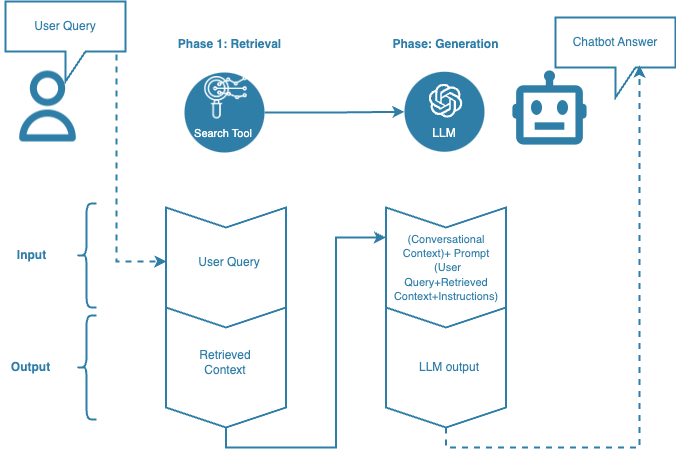

Il seguente schema rappresenta il workflow operativo di un processo di Retrieval Augmented Generation:

- Search Tool: strumento di ricerca. Nell’approccio RAG, è possibile integrare sia strumenti di ricerca già esistenti (ad esempio il motore di ricerca prodotti del sito) sia strumenti sviluppati su misura. In quest’ultimo caso, l’approccio più comune consiste nel predisporre un database vettoriale per effettuare ricerche semantiche.

- LLM: Large Language Model. Modello di AI generativa utilizzato per la creazione o rielaborazione di contenuto testuale. È lo strumento che gestisce la fase di “Generation”.

- Retrieval: fase di recupero dell’informazione rilevante (Retrieved Context) a partire dalla Knowledge Base di progetto.

- Generation: fase di generazione della risposta da parte dell’LLM, a partire dall’output della fase di Retrieval (Retrieved Context), delle eventuali interazioni precedenti (Conversational Context), della domanda dell’utente (User Query) e delle istruzioni fornite (Instructions)

- User Query: Domanda o richiesta dell’utente

- Retrieved Context: Informazione recuperata dalla Knowledge Base di progetto sulla base della User Query. Il Retrieved Context è l’output della fase di Retrieval.

- Conversational Context: insieme delle eventuali interazioni precedenti (prompt+output) nella conversazione corrente con l’LLM

- Prompt: Input per l’LLM di una singola interazione. Nel prompt è possibile includere la User Query, il Retrieved Context e delle istruzioni (Instructions) per guidare la generazione della risposta.

- Instructions: parte del prompt in cui si istruisce l’LLM su come gestire la User Query utilizzando il Retrieved Context.

- LLM Output: output generato dall’LLM a seguito di un prompt.

- Chatbot Answer: risposta data dal chatbot all’utente finale. Tale risposta può coincidere con l’LLM output o può comportare un certo grado di post processing.